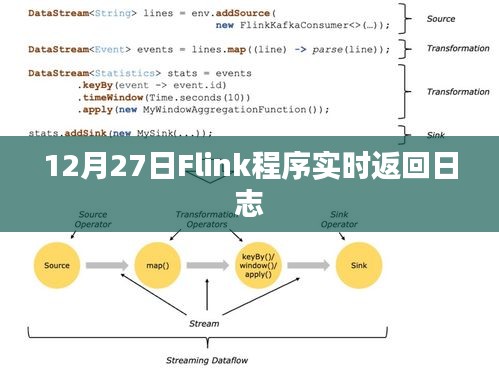

随着大数据技术的不断发展,实时数据处理成为了企业和研究机构关注的重点,Apache Flink作为一个开源的流处理框架,因其高可用性、高吞吐量和低延迟的特性而备受青睐,本文将介绍在12月27日使用Flink进行程序运行时,如何通过实时返回日志来监控和优化程序性能。

Flink概述

Apache Flink是一个用于进行流处理和批处理的开源框架,它支持高并发、高吞吐量的数据处理,同时保证了毫秒级的延迟,Flink的架构允许其在集群中运行,并提供了丰富的API来简化开发过程,Flink还提供了强大的监控和诊断工具,帮助开发人员实时了解程序的运行状态。

实时返回日志的重要性

在Flink程序运行过程中,实时返回日志是监控和优化程序性能的关键手段,通过查看日志,我们可以了解程序的运行状态、资源使用情况、错误信息等,这对于及时发现和解决问题,以及优化程序性能至关重要。

如何获取和使用Flink的实时返回日志

1、配置日志级别:在Flink程序中,我们可以通过配置日志级别(如INFO、WARN、ERROR等)来获取不同详细程度的日志信息。

2、使用Flink的监控工具:Flink提供了Web UI等监控工具,可以实时查看程序的运行状态和日志信息。

3、编写自定义日志:在关键代码段中添加自定义日志输出,以便更好地了解程序的运行情况和性能瓶颈。

日志分析与应用

在获取实时返回日志后,我们可以进行以下分析与应用:

1、检查错误和警告:查看日志中的错误和警告信息,及时发现并解决问题。

2、性能分析:通过分析日志中的性能指标,如任务延迟、资源利用率等,找出程序的性能瓶颈。

3、优化调整:根据日志分析结果,对程序进行优化调整,如调整并行度、优化算法等。

案例分享

假设在12月27日,我们使用Flink处理实时流数据,通过查看实时返回日志,我们发现程序的延迟突然增加,通过分析日志,我们发现是由于某个任务的并行度设置不合理导致的,我们调整了任务的并行度,并重新运行程序,通过对比调整前后的日志,我们发现程序的延迟得到了显著优化。

本文介绍了在Flink程序运行过程中,如何获取和使用实时返回日志来监控和优化程序性能,通过配置日志级别、使用Flink的监控工具和编写自定义日志,我们可以获取丰富的日志信息,通过分析日志中的错误、警告和性能指标,我们可以及时发现和解决问题,并对程序进行优化调整,通过案例分享展示了实时返回日志在优化Flink程序性能中的应用。

转载请注明来自河南双峰网袋厂,本文标题:《12月27日Flink实时日志反馈程序运行细节》

豫ICP备19030322号-1

豫ICP备19030322号-1

还没有评论,来说两句吧...