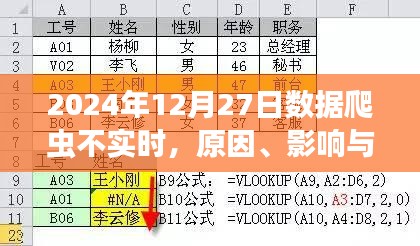

背景介绍

随着互联网的普及和大数据时代的到来,数据爬虫技术在数据采集、处理和分析方面发挥着越来越重要的作用,在2024年12月27日这一天,许多数据爬虫用户发现他们所使用的技术并不如预期那样实时,这引发了业界的高度关注,本文将围绕这一现象展开分析,探讨数据爬虫不实时的原因、影响,并提出相应的解决方案。

数据爬虫不实时的原因

1、网络延迟:互联网本身的传输速度受到多种因素的影响,网络延迟可能导致数据爬虫无法及时获取最新信息。

2、数据源更新频率:部分数据源更新速度较慢,导致爬虫抓取到的数据并非实时数据。

3、爬虫程序设置:部分爬虫程序在抓取数据时设置了时间间隔,以避免对目标服务器造成过大压力,这也可能导致数据不实时。

4、技术限制:当前爬虫技术的局限性可能导致无法抓取动态生成的数据,从而影响数据的实时性。

影响分析

1、决策失误:对于需要实时数据的领域,如股市、新闻等,数据爬虫不实时可能导致决策者无法做出准确的判断。

2、数据质量下降:非实时的数据可能导致数据分析结果的滞后,从而影响数据质量。

3、业务受损:对于依赖实时数据的业务,如广告投放、金融交易等,数据爬虫不实时可能导致业务受损。

4、用户体验下降:用户在使用某些应用时,若数据更新不及时,可能导致用户体验下降,进而影响产品的市场竞争力。

解决方案

针对数据爬虫不实时的问题,可以从以下几个方面着手解决:

1、技术升级:改进爬虫技术,提高爬取动态生成数据的能力,确保数据的实时性。

2、优化数据源选择:选择更新速度快、实时性强的数据源,以提高数据的时效性。

3、调整爬虫策略:根据实际情况调整爬虫程序的时间间隔设置,确保在不影响目标服务器的前提下尽可能提高数据抓取频率。

4、结合其他技术手段:可以考虑结合使用API、实时数据库等技术手段来获取实时数据。

案例分析

以股市数据分析为例,若数据爬虫不实时,可能导致投资者无法及时获取最新股市信息,从而影响投资决策,针对这一问题,可以采取以下措施:

1、选择专业的金融数据服务商提供的API接口获取实时数据。

2、结合使用多个数据源进行校验,以确保数据的准确性。

3、采用高性能的爬虫技术,提高数据抓取速度。

数据爬虫不实时是一个需要关注的问题,特别是在对实时性要求较高的领域,通过改进技术、优化策略、选择合适的数据源等手段,可以有效解决这一问题,随着技术的不断发展,未来数据爬虫的实时性将得到进一步提升,为各个领域带来更多价值。

转载请注明来自河南双峰网袋厂,本文标题:《数据爬虫不实时问题解析,原因、影响及解决方案(日期更新)》

豫ICP备19030322号-1

豫ICP备19030322号-1

还没有评论,来说两句吧...